革命性AI创新!一句话即可打造震撼120秒超长视频,免费开源,引爆你的创作激情!

革命性AI创新!一句话即可打造震撼120秒超长视频,免费开源,引爆你的创作激情!

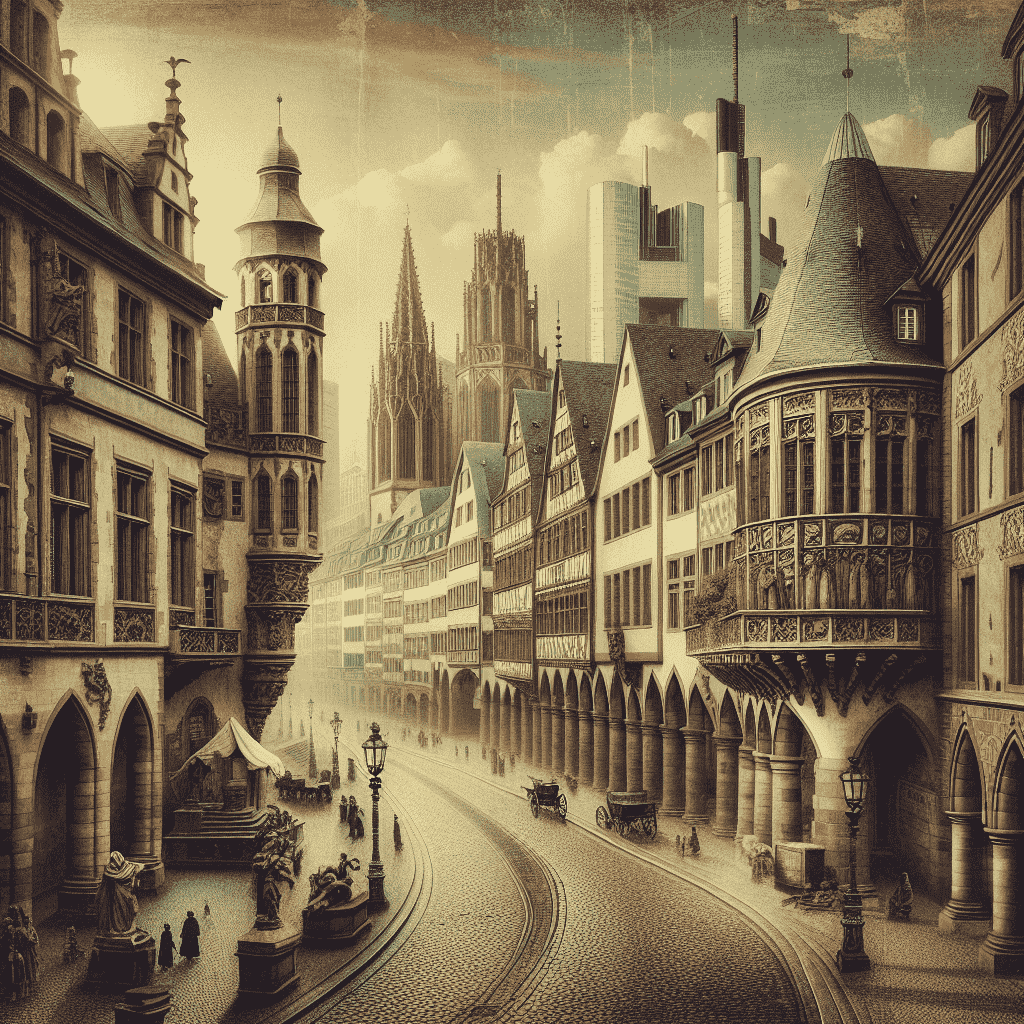

罗布斯# 欣赏 AI 生成的视频效果

最新发布的 StreamingT2V 模型,由 Picsart AI Research 团队倾力打造,引领视频生成领域的革新!超越 Sora 模型,轻松创造长达 2 分钟(1200 帧)的高品质视频!更令人振奋的是,

这一开源模型与 SVD、animatediff 等其他模型完美兼容,为视频生成领域带来了前所未有的突破!

# 亮点总结

- 创造长达 2 分钟(1200 帧)的视频,超越以往模型

- 视频质量卓越,呈现高品质效果

- 与其他主流模型实现无缝衔接,提供更多创作可能性

- 开源免费,方便开发者使用和进行二次开发

# 免费体验

免费在线试玩:点击跳转

# 本地搭建

1 | git clone https://github.com/Picsart-AI-Research/StreamingT2V.git |

- 安装必备的环境:

1 | conda create -n st2v python=3.10 |

可选如果您的系统上缺少 FFmpeg,请安装 FFmpeg

1 | conda install conda-forge::ffmpeg |

-

从 huggingface 下载模型并将它放在

t2v_enhanced/checkpoints目录下 -

文本转视频

1 | cd t2v_enhanced |

# 基础模型推理时间对比

# ModelscopeT2V 作为基础模型

| 帧数 | 更快预览的推理时间 (256×256) | 最终结果的推理时间 (720×720) |

|---|---|---|

| 24 帧 | 40 秒 | 165 秒 |

| 56 帧 | 75 秒 | 360 秒 |

| 80 帧 | 110 秒 | 525 秒 |

| 240 帧 | 340 秒 | 1610 秒(约 27 分钟) |

| 600 帧 | 860 秒 | 5128 秒(约 85 分钟) |

| 1200 帧 | 1710 秒(约 28 分钟) | 10225 秒(约 170 分钟) |

# AnimateDiff 作为基础模型

| 帧数 | 更快预览的推理时间 (256×256) | 最终结果的推理时间 (720×720) |

|---|---|---|

| 24 帧 | 50 秒 | 180 秒 |

| 56 帧 | 85 秒 | 370 秒 |

| 80 帧 | 120 秒 | 535 秒 |

| 240 帧 | 350 秒 | 1620 秒(约 27 分钟) |

| 600 帧 | 870 秒 | 5138 秒(~85 分钟) |

| 1200 帧 | 1720 秒(约 28 分钟) | 10235 秒(约 170 分钟) |

# SVD 作为基本模型

| 帧数 | 更快预览的推理时间 (256×256) | 最终结果的推理时间 (720×720) |

|---|---|---|

| 24 帧 | 80 秒 | 210 秒 |

| 56 帧 | 115 秒 | 400 秒 |

| 80 帧 | 150 秒 | 565 秒 |

| 240 帧 | 380 秒 | 1650 秒(约 27 分钟) |

| 600 帧 | 900 秒 | 5168 秒(~86 分钟) |

| 1200 帧 | 1750 秒(约 29 分钟) | 10265 秒(~171 分钟) |

所有测量均使用 NVIDIA A100 (80 GB) GPU 进行。当帧数超过 80 时,采用随机混合。对于随机混合,chunk_size 和 的值 overlap_size 分别设置为 112 和 32。

更多的文生视频在线使用:点击前往 支持多模型自由切换!

评论

匿名评论隐私政策

TwikooGitalk

✅ 你无需删除空行,直接评论以获取最佳展示效果